El atomismo y la física clásica

El atomismo antiguo intenta solucionar el problema del cambio, tal como fue planteado por Heráclito y por Parménides, por medio de la reducción de las cualidades de color, temperatura, sabor, olor, etc., al simple aspecto espacial de forma, orden y agrupación de entidades indivisibles, perfectamente compactas, los átomos. La inmensa variedad fenoménica del mundo físico no es más que apariencia.

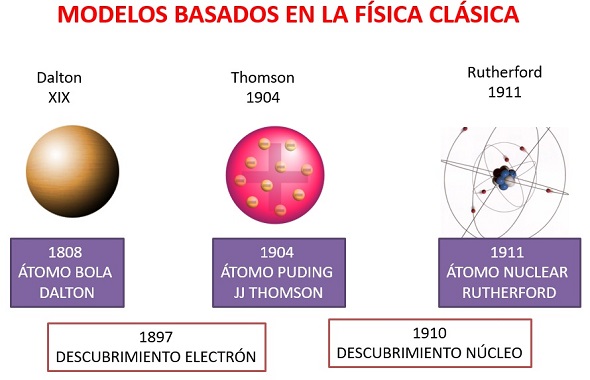

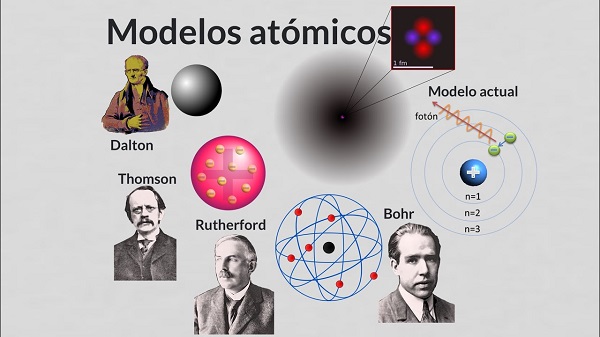

A pesar de su genial simplicidad, la escuela atomista pasa por la historia de la ciencia sin dejar rastro digno de mención hasta el siglo XVIII, cuando es revivida de manera vigorosa, y bajo una perspectiva diferente, por un químico inglés John Dalton (1766-1844). La causa de este largo olvido hay que colocarla en el inmenso prestigio de Platón y de Aristóteles, enemigos acérrimos del atomismo. Para estos dos grandes filósofos carecía por completo de sentido la pretensión de reducir la cualidad, y con ello la vida misma, a condiciones puramente geométricas.

John Dalton.

John Dalton.

Si los átomos de Leucipo y Demócrito carecen de cualidades, no son ni calientes ni fríos, ni secos ni húmedos, etc., los cuatro elementos de Aristóteles, que son los mismos elementos propuestos por Empédocles, poseen, en cambio, las cualidades fundamentales a partir de las cuales se explican las demás cualidades de la naturaleza física. La Tierra es fría y seca; el Agua, fría y húmeda; el Aire, húmedo y caliente; el Fuego, caliente y seco. Si en una parte del elemento Tierra, la sequedad se transforma en humedad, entonces esa parte se transforma en agua. Si en una parte del elemento Agua, lo frío se transforma en caliente, entonces esa parte de agua se transforma en aire, y así sucesivamente. Pero no sólo es posible la transformación de parte de un elemento en otro, sino que también es posible la diferenciación de las partes en un mismo elemento, a causa de los diferentes grados de intensidad en una misma cualidad. La sequedad, por ejemplo, no es una cualidad absoluta, admite grados, como admite grados el frío. El Agua es fría y húmeda, pero hay porciones de agua más frías que otras, por ejemplo, el hielo comparado con el agua común.

Dentro del esquema aristotélico de los cuatro elementos, cada uno de los cuales es sostén o sujeto de un par de cualidades fundamentales, se mueve la investigación de la naturaleza durante la Edad Media hasta finales del siglo XVIII y comienzos del XIX, como lo muestra la historia de la química en su forma más primitiva, la Alquimia o ciencia de la transmutación de los metales. ¿Qué son los metales? se preguntaron los alquimistas. La respuesta, dentro de la teoría de los cuatro elementos aristotélicos, no es complicada. O son Tierra con un alto grado de sequedad, o son la mezcla de varios elementos con predominio del elemento fuego. ¿No se obtienen, acaso, los metales calentando diferentes clases de tierra, hasta fundirlas? ¿Se quiere obtener oro? Nada más simple, en teoría: hay que quemar, calcinar, fundir, destilar y repetir la operación sin desfallecer, hasta que la tierra pierda cualquier vestigio de humedad, si se trata de una mezcla, o hasta que el elemento Tierra adquiera el máximo grado de sequedad posible.

Bernardo Trevisan (1406-1490) es buen ejemplo del alquimista sincero en medio de una inmensa muchedumbre de charlatanes. Gastó toda su fortuna, viajó por toda Europa, leyó manuscritos antiguos, preguntó a los más renombrados alquimistas de su tiempo acerca del procedimiento para obtener oro, el más precioso de los metales, a partir del cobre, o del hierro, o de la simple arena del mar. Esta prodigiosa transmutación era perfectamente posible, bastaba estar de acuerdo con la teoría de los cuatro elementos de Aristóteles. Trevisan ensaya, sin orden, confiando más en un golpe de suerte que en la comprobación de una hipótesis, que nunca tuvo. Mezcla plomo, mercurio, le añade unas gotas de aceite, pone la mezcla al fuego, espera uno, dos tres días, una semana, destila, tritura, vuelve a calentar. ¡Nada! Repite una y otra vez, cambia los ingredientes, y así, inútilmente, por más de 50 años.

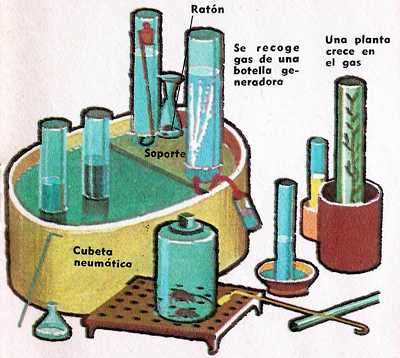

La teoría de los cuatro elementos comienza a derrumbarse con el descubrimiento de que no eran tan simples como se había supuesto durante más de 2000 años. En 1774 un ministro inglés, presbiteriano, descubre casualmente que el aire común contiene un gas invisible, más saludable que el aire común y que favorecía la combustión, le dio el nombre de aire desflogisticado. J. Priestley calentó mercurio hasta obtener un polvo rojizo, que se conocía entonces con el nombre de mercurio calcinado. Hasta aquí no había nada nuevo. Calentó nuevamente este polvo dentro de un recipiente cerrado. Se le ocurrió introducir dentro del recipiente una vela encendida que tenía a su lado. La llama no se extinguió, antes por el contrario, brilló con más esplendor. Introdujo en seguida un carbón encendido, luego, un alambre incandescente, observando el mismo fenómeno. Dentro de dos campanas, la una con aire común, la otra con aire desflogisticado, introdujo sendos ratones. El ratón dentro de la campana con aire desflogisticado vivió tres veces más tiempo que el otro. El mismo Priestley respira el nuevo aire y nota que su respiración se hace más fácil. Escribe, entonces, «este gas puede ser peculiarmente saludable para los pulmones en ciertos casos mortales». Priestley había descubierto el oxígeno. ¿Pero se trata realmente de un componente del aire común? Priestley sospecha que el aire liberado por el mercurio calcinado fue adquirido por este a partir del aire común en su primer calentamiento o calcinación. Para comprobar su hipótesis calcina plomo. Calienta el plomo calcinado dentro de un recipiente, obteniendo, de acuerdo con lo previsto, el mismo aire desflogisticado de la primera experiencia. Por consiguiente, este «aire» no proviene ni del mercurio, ni del plomo, proviene del aire común, es decir, de uno de los cuatro elementos aristotélicos.

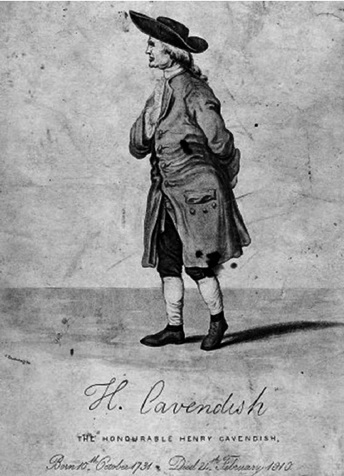

Por el mismo tiempo, otro inglés, Henry Cavendish hace experiencias con «aires artificiales». La pregunta fundamental de la química de entonces era la pregunta acerca de la naturaleza del fuego. ¿Se trataba realmente de una sustancia, de una especie de fluido? y si así era, ¿se podría almacenar en un recipiente como cualquier otra sustancia? Cien años antes, un célebre alquimista, Joahim Becher, había enseñado que el fuego era una sustancia peculiar, que denominó tierra aceitosa, y, más tarde, «flogisto», es decir, sustancia «que arde». En la combustión el flogisto escapa violentamente en forma de llama, en la herrumbre de los metales, el flogisto escapa lentamente sin ser percibido, y en la calcinación el flogisto escapa rápidamente sin ser percibido. Becher sostenía además que los metales eran compuestos de tierra y de flogisto. Cavendish, como la mayor parte de sus contemporáneos, acepta la teoría de Becher. Si es posible obtener el misterioso flogisto, este debe obtenerse tratando químicamente los metales.

Henry Cavendish.

Henry Cavendish.

Cavendish recoge «aires», liberados al mezclar en diferentes recipientes cinc, hierro y estaño con ácido sulfúrico. Estos gases incoloros arden con una llama azul pálida, sin dejar el menor rastro de cenizas, humo o algo semejante. Se trata de un mismo gas, que procede de los metales, y que arde sin dejar residuos. ¿Se tratará, acaso, del escurridizo fluido de Becher, del Flogisto, del Fuego en el sentido aristotélico? Cavendish repite la experiencia empleando ácido clorhídrico en lugar de sulfúrico. El resultado es idéntico. No hay duda, se trata de flogisto. Más aún, una meticulosa serie de experimentos muestran que el flogisto, aunque invisible a la vista, tiene peso, se puede almacenar, transportar. Cavendish comunica el resultado de sus experimentos a la Sociedad Real de Londres, la noticia se riega por toda Europa, otro elemento aristotélico ha sido destronado de su lugar de privilegio. Este nuevo aire, que Cavendish denomina aire flogisticado, no es más que lo que nosotros conocemos hoy en día como hidrógeno.

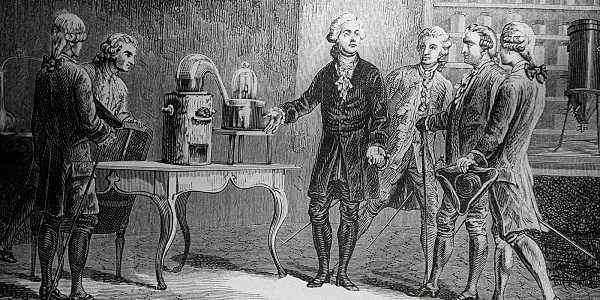

¿Qué sucede si se mezclan el aire desflogisticado de Priestley con el aire flogisticado de Cavendish? Cavendish lo intenta, hace saltar una chispa eléctrica en un recipiente con la mezcla de los dos gases. Su asombro no tiene límites, las masas de los gases ya no son iguales, pero en lugar encuentra unas gotas de agua. No fue tarea fácil convencer a los honorables miembros de la Sociedad Real de Londres de que el elemento vital de Tales de Mileto, el elemento fundamental de Empédocles y de Aristóteles, no era más que un compuesto, según una proporción fija, de dos aires, el oxígeno y el hidrógeno, de acuerdo con nuestra nomenclatura actual. Pero en la ayuda de Cavendish llega un francés, A.L. Lavoisier, quien después de haber oído acerca de los experimentos de Cavendish inicia una serie de experimentos irrefutables. Sus resultados son los mismos, el agua no es una sustancia simple. Comunica el resultado de sus investigaciones en 1770 a la Academia Real de Ciencias de París en una bella monografía con el título «Investigaciones acerca de la composición del agua».

Lavoisier.

Lavoisier.

Hacia mediados del siglo XVIII, los cuatro elementos iniciales se han ido multiplicando: oxigeno, hidrógeno, nitrógeno, mercurio, azufre, sodio, cloro, fósforo, etc. Surge, entonces, la pregunta acerca del concepto mismo de elemento. Evidentemente, los átomos de Leucipo y Demócrito, los cuatro elementos aristotélicos, y los elementos de la química del siglo XVIII tienen nada o casi nada en común. ¿Qué se entiende, o mejor qué se debe entender por elemento? Lavoisier, en su Tratado elemental de química (1789) propone una definición que significa un cambio total con respecto a toda tradición anterior: se entiende por elemento lo que no puede ser descompuesto químicamente con los medios disponibles. No más teorización, no más generalización injustificada. El análisis químico es quien decide sobre la simplicidad o no simplicidad de una sustancia.

John Dalton se sintió cautivado desde muy joven por el enigma de la composición del aire común. El aire estaba compuesto por cuatro gases, como había demostrado Priestley, D. Rutherford, Cavendish y Lavoisier, a saber: oxígeno, nitrógeno, bióxido de carbono y vapor de agua. ¿Pero cómo explicar que en esta mezcla el oxígeno, que es el más liviano, no se encontrara preferentemente en las capas superiores de la atmósfera? El mismo había tomado multitud de muestras, en valles, en las cimas de montañas, sin encontrar diferencia apreciable en la composición de la mezcla. Más aún, Gay-Lusac había tomado muestras de aire común a 21 000 pies de altura sobre París con el mismo resultado. Durante varios años Dalton buscó inútilmente una respuesta, hasta que un día quiera tuvo noticia, posiblemente a través de la lectura de P. Gassendi, de la teoría atomista antigua. ¿Y si el supone que cada uno de los gases atmosféricos está compuesto de átomos, con pesor diferentes para diferentes gases, pero idénticos para el mismo gas? Entonces, pensó Dalton, es posible explicar la homogeneidad de la mezcla. En la atmósfera sucede algo semejante a lo que sucedería en un gran remolino de agua que agitara partículas de arena de diferentes tamaños y pesos: las diferentes muestras extraídas serían muy semejantes en su composición.

Dalton.

Dalton.

Dalton dio a conocer su hipótesis atómica en «Un nuevo sistema de filosofía química», que apareció en dos etapas, en 1808 y en 1810. De acuerdo con la nueva hipótesis atómica:

1. La materia consta de átomos indivisibles.

2. Los átomos de diferentes elementos son diferentes en tamaño y peso, y los átomos de un mismo elemento son idénticos en tamaño y peso.

3. Los átomos son inmodificables. No se puede cambiar ni su tamaño ni su peso.

4. Las reacciones químicas no son más que intercambios de átomos.

5. Cuando dos o más elementos se combinan químicamente, la mínima parte del compuesto consta de un número determinado de átomos de cada uno de los elementos participantes. La cantidad mínima de un compuesto se llama «átomo compuesto» (molécula).

Humphry Davy, contemporáneo de Dalton, y uno de los químicos más notables de Inglaterra rechazó la hipótesis atómica por ridícula, «¿cómo puede un hombre de sentido común o de ciencia comprometerse con un retazo semejante de absurdos?» Sin embargo, el modelo atómico de Dalton se fue imponiendo inexorablemente sobre sus más acérrimos enemigos, a causa de la simplicidad y coherencia con que explicaba las leyes fundamentales de la química y algunos de los principios físicos universalmente aceptados. A saber:

1. Ley de la conservación de las masas: la masa final del compuesto es igual a la suma de las masas de las sustancias reaccionantes.

2. Ley de las proporciones constantes: los elementos se combinan entre sí según una proporción fija e invariable de masas.

3. Ley de las proporciones múltiples: si una masa determinada de una sustancia se combina con diferentes cantidades de masa de otra sustancia, entonces, estas cantidades de masas de la segunda sustancia son entre sí como los números enteros sencillos. Por ejemplo: 7 gramos de nitrógeno se pueden combinar, dando diferentes compuestos, o con 4 gramos de oxígeno, o con 8, o con 12, nunca con 5, 6 o 9. Es decir, m1: m2: m3 = 4:8:12=1:2:3.

4. Ley de la teoría cinética del calor.

5. Cambios de los estados de la materia (sólido, líquido, gaseoso).

A partir de 1833, con las investigaciones de Miguel Faraday sobre la descomposición por electrólisis, se comenzó a sospechar una fuerte conexión entre los átomos y la electricidad. Hasta entonces la teoría predominante consideraba la electricidad como un fluido. Experimentos posteriores mostraron que la electricidad era también de naturaleza corpuscular (J.J. Thomson, 1897; R.A. Millikan, 1909). A pesar de sus invaluables servicios, sobre todo en el campo de la química, el modelo atómico de Dalton tenía que ser modificado para dar cabida a los fenómenos eléctricos y magnéticos. Solamente se llegó a un nuevo modelo, más satisfactorio, a comienzos del siglo XX.

W.C. Röntgen, descubridor de los rayos-X, había notado que estos rayos al incidir sobre ciertas sustancias las hacían fluorescentes. El francés, Henri Becquerel inició una serie de investigaciones sobre el fenómeno de la fluorescencia; para esto utilizó ciertas sales fluorescentes de uranio. Comprobó que la fluorescencia estaba acompañada por una emisión de rayos, capaces de impresionar una película fotográfica, a pesar de estar protegida por un papel impermeable a la luz. Pero lo más sorprendente fue el descubrimiento de que otras sales de uranio, no fluorescentes, tenían la propiedad de impresionar en forma semejante, a través de un papel impermeable a la luz, una película fotográfica. Se trataba, por consiguiente, de un tipo de radiación especial, producida por las sales de uranio, fluorescentes o no. Becquerel le dio el nombre de rayos de uranio. En 1897, una estudiante de física y de química, Marie Curie Sklodowska, inició el estudio metódico de los rayos de uranio. Encontró que además del uranio el torio emitía el mismo tipo de rayos. Más tarde encontró otros dos nuevos elementos químicos, hasta entonces desconocidos, el polonio y el radio. Este último resultó ser cien mil veces más activo que el uranio con el que se inició la serie de ensayos. Con una fuente tan poderosa se pudo rápidamente llegar a conclusiones definitivas sobre la naturaleza de los misteriosos rayos descubiertos años antes por Becquerel. Estos rayos estaban compuestos por tres tipos de radiaciones. Marie Curie las denominó alfa, beta y gama, con las primeras letras del alfabeto griego. Los rayos beta consisten en una intensa lluvia de partículas supremamente pequeñas, con cargas negativas, es decir, de electrones. Los rayos gama son rayosX, de un gran poder de penetración y, finalmente, los rayos alfa consisten en una lluvia de partículas, más lentas que las partículas alfa y con una masa mayor, cargadas positivamente. Más tarde se las identificó como iones-helios positivos.

Marie Curie.

Marie Curie.

¿De dónde provenían estos tres tipos de radiaciones? Evidentemente de los átomos supergigantes del radio. ¿Cómo? No había más remedio que aceptar que los átomos de radio estallaban como burbujas de jabón dejando al descubierto una estructura interna, íntimamente relacionada con la electricidad. Los últimos componentes de la materia no eran pues, como había supuesto Dalton, los átomos. Estas pequeñas esferas macizas, indivisibles, inmodificables, tenían una estructura interna hasta entonces insospechada.

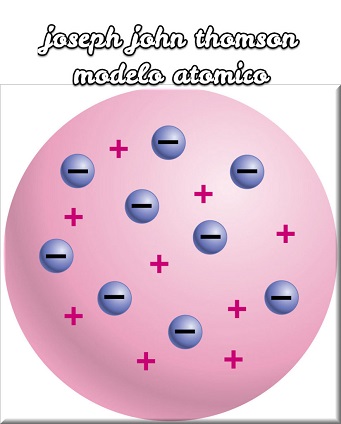

En 1904 J.J. Thomson propone un nuevo modelo atómico, semejante al modelo de Dalton, pero con una estructura interna que explica la relación del átomo con la electricidad. Los nuevos átomos son pequeñas esferas de materia, cargadas positivamente, dentro de estas esferas se encuentran en lugares perfectamente definidos y en reposo partículas muy pequeñas, cargadas negativamente, los electrones, de manera que las fuerzas electrostáticas positivas y negativas se equilibran. En ciertas circunstancias, un átomo puede perder algunos de los electrones periféricos, convirtiéndose en un ion positivo, o puede adquirir uno o más electrones, convirtiéndose en un ion negativo.

El modelo de J.J. Thomson encontró, sin embargo, bien pronto, dificultades insalvables. El grosor de 0,002 mm de una lámina de aluminio equivale a una fila de aproximadamente 7500 átomos. Ahora bien, si se supone, como corresponde a los cuerpos sólidos, que estos átomos están en contacto los unos con los otros, no parece probable que una partícula, por pequeña que sea, disparada contra esta lámina, la pueda atravesar. En 1894, físico alemán Philip Lenard hace incidir una haz de rayos catódicos (electrones) sobre una lámina de aluminio del grosor arriba indicado. Asombrado, encontró que las partículas atravesaban sin dificultad una barrerá tan formidable. El experimento de Lenard contradice, sin duda, la suposición de que los átomos son esferas de materia compactas, como pretendía Thomson. De acuerdo con el experimento de Lenard había que suponer que la masa estaba distribuida o concentrada en una fracción relativamente pequeña del volumen total del átomo.

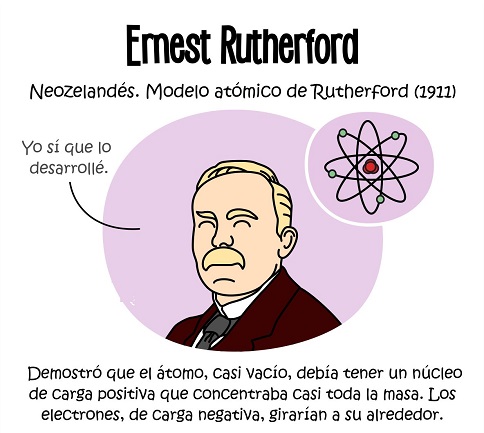

E. Rutherford repite la experiencia de Lenard en condiciones semejantes, pero en lugar de electrones utiliza las recién descubiertas partículas alfa, cuya masa es 7300 veces mayor que la de los electrones, aunque su tamaño es aproximadamente igual. Los experimentos realizados mostraron que la mayor parte de las partículas atravesaba la lámina de aluminio sin pérdida apreciable de energía y sin desviación de la trayectoria inicial. Algunas partículas eran desviadas en mayor o menor grado, y en algunos casos excepcionales las partículas eran devueltas frontalmente. Estos resultados llevan a las siguientes conclusiones:

1. El espacio que corresponde a las esferas atómicas debe estar en su mayor parte vacío. La materia no está, como pretendía el modelo Thomson, uniformemente distribuida.

2. Como las partículas alfa tienen una masa mucho mayor que la de los electrones, las desviaciones no se pueden explicar por el choque de estas partículas con los electrones. Las desviaciones se deben más bien al rechazo por parte de las cargas positivas, de acuerdo con la ley de Coulomb. Suponer que estas desviaciones se debían al choque con los electrones sería tanto como suponer, según lo explica con un ejemplo el mismo Rutherford, «que un proyectil de 10 pulgadas rebote y nos hiera a nosotros mismos al hacer fuego contra un pedazo de papel de seda».

3. El rebote frontal de algunas partículas alfa no se puede explicar si no se supone, de acuerdo con ley de Coulomb, que la carga positiva del átomo se encuentra condensada en un espacie supremamente pequeño, del orden de la diezmilésima del diámetro del átomo.

4. Como las partículas alfa no experimentan pérdida de energía cinética en su interacción con las cargas positivas del átomo, es preciso suponer que la masa asociada con estas cargas es relativamente grande, de acuerdo con las leyes del choque elástico, y por consiguiente, que la casi totalidad de la masa atómica está concentrada en una pequeña región, cuyo diámetro es aproximadamente una diezmilésima del diámetro atómico.

De acuerdo con las consideraciones anteriores, Rutherford propone un nuevo modelo atómico en 1911: el átomo es un sistema planetario en escala microscópica. En el centro, un núcleo cargado positivamente, en la periferia, partículas de materias pequeñísimas, cargadas negativamente, que como los planetas, giran a grandes velocidades en tomo a una masa central, el núcleo atómico.

Para formarse una imagen intuitiva de las dimensiones relativas en el átomo de Rutherford, supongamos que se aumentara un átomo de hidrógeno hasta alcanzar un diámetro de 30 m. En este modelo artificial el núcleo correspondería a una partícula de materia del tamaño de una cabeza de alfiler (1 mm): el electrón correspondería a un grano de polvo casi imperceptible que giraría a 30 m de distancia del núcleo a una velocidad prodigiosa.

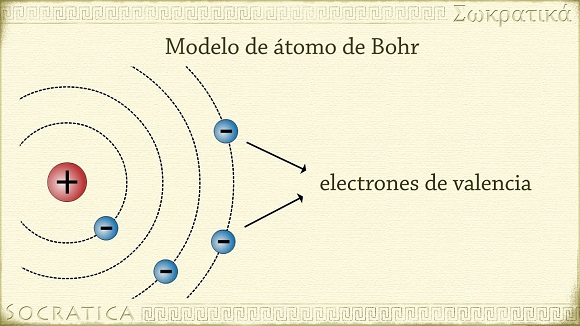

El modelo de Rutherford constituye el modelo atómico de la física clásica. Pronto será reemplazada por el modelo de Niels Bohr, y este a su vez es refinado por Sommerfield, y así sucesivamente, hasta llegar al momento actual de la física moderna, en donde ya no es posible la representación imaginativa del átomo.

Hoy, como antes, volvemos a preguntar, ¿consta o no la materia de partículas homogéneas, indivisibles? ¿Hay o no un último constitutivo de la materia? Ciertamente los átomos de Dalton no son los últimos constitutivos de la materia. Los átomos están constituidos por corpúsculos más elementales los electrones, los protones y neutrones del núcleo, etc. Pero hay todavía partículas más elementales. Y volvemos a preguntar, ¿dado nuestros conocimientos actuales, es posible admitir, a nivel de simple hipótesis la existencia de constitutivos últimos? Algunos físicos teóricos defienden tal posibilidad, más aún, le han dado un nombre a esta piedra fundamental de todo el edificio de la materia: Quarks.

Últimos Articulos

- Decreto 0277 de 2025. Horario de la jornada escolar, asignación académica y el cumplimiento de la jornada laboral en establecimientos educativos estatales

- Mapa de Colombia: Áreas protegidas

- Mapa de Brasil: Regiones administrativas

- Mapa Brasil: Regiones naturales

- Mapa de Argentina: Regiones naturales

- Mapa ecológico de Colombia

- Mapa cultural de Colombia para colorear

- Mapa de Colombia: Topografía

- Mapa de Chile Tricontinental

- Mapa de Bolivia: Regiones naturales

- Mapa de Chile: Regiones naturales

- Mapa de Paraguay: Regiones naturales

- Mapa de Ecuador: Regiones naturales

- Mapa de Venezuela: Regiones naturales

- Roma monárquica: Otros pueblos itálicos

Notas de interés

- Decreto 0277 de 2025. Horario de la jornada escolar, asignación académica y el cumplimiento de la jornada laboral en establecimientos educativos estatales

- Mapa de Colombia: Áreas protegidas

- Mapa de Brasil: Regiones administrativas

- Mapa Brasil: Regiones naturales

- Mapa de Argentina: Regiones naturales

- Mapa ecológico de Colombia

- Mapa cultural de Colombia para colorear

- Mapa de Colombia: Topografía

- Mapa de Chile Tricontinental

- Mapa de Bolivia: Regiones naturales

- Mapa de Chile: Regiones naturales

- Mapa de Paraguay: Regiones naturales

- Mapa de Ecuador: Regiones naturales

- Mapa de Venezuela: Regiones naturales

- Roma monárquica: Otros pueblos itálicos

- Roma monárquica: Los etruscos

- Roma monárquica: La Reforma de Servio Tulio

- Roma monárquica: La guerra contra los sabinos

- Roma monárquica: Los siete reyes

- Mapa de Colombia: Departamentos, capitales y ciudades importantes

Filosofía

- Existencialismo

- El atomismo y la física clásica

- Albert Camus

- La forma del universo: Cosmogonías modernas

- ¿Cuándo hablamos de filosofía?

- El saber humano

- Origen de la filosofía

- El método

- El proceso histórico de la filosofía

- Grecia: Cuna de la civilización occidental

- La lógica

- La lógica clásica o aristotélica

- Filosofía moral

- Filosofía de la mente

- Immanuel Kant

- Los métodos filosóficos

- Cicerón

- Agustín de Hipona

- Dios

- El atomismo

- Ética social

- Filosofía analítica

- Filosofía de la ciencia

- Heráclito de Éfeso: El cambio

- Intento de solución: Anaxágoras y Empédocles

- John Locke

- La escuela de Mileto

- La escuela Pitagórica

- La ética

- Las matemáticas y el conocimiento de la naturaleza

- Los Sofistas

- Parménides: El Ser

- Platón (427-347 a.C.)

- Platón: El alma humana

- Platón: El Demiurgo

- Platón: El mundo de las ideas

- Platón: Ideas principales

- Posestructuralismo

- Sócrates: Conócete a ti mismo